Come Apple progetta le fotocamere per iPhone

Il Product Manager dell’iPhone. Francesca Sweet e Jon McCormack, Vice President of Camera Software Engineering di Apple, parlano in un’intervista su PetaPixel di come Apple affronta la progettazione e lo sviluppo delle fotocamere.

Secondo i dirigenti, Apple vede la tecnologia inclusa nella fotocamera dell’iPhone come un’unione olistica tra hardware e software.

Nell’intervista, si dice che Apple vede come obiettivo principale per la fotografia degli smartphone consentire agli utenti di «rimanere nel momento, scattare una foto eccezionale e continuare con ciò che stavano facendo» senza essere distratti dalla tecnologia dietro di essa.

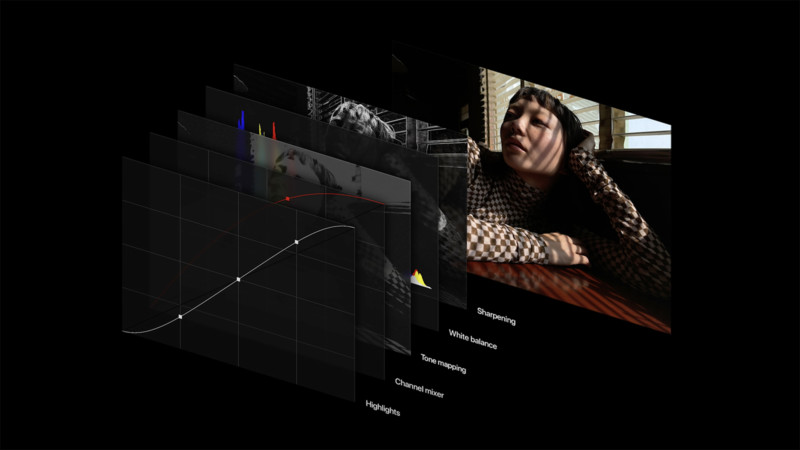

McCormack spiega che sebbene i fotografi professionisti passino attraverso un intero processo di ritocco delle immagini, Apple cerca di rendere le foto perfette nel momento in cui viene premuto il pulsante di scatto.

«Abbiamo cercato di replicare il più possibile ciò che il fotografo farebbe in post-produzione», afferma McCormack. “Ci sono due aspetti nello scattare una fotografia: l’esposizione e il modo in cui la ritocchi in seguito. Usiamo molto la fotografia computazionale in mostra, ma sempre più in post-produzione e tutto viene fatto automaticamente per l’utente. L’obiettivo di questo è produrre fotografie che sembrino più realistiche, replicando come sarebbe essere fisicamente lì”.

Quanto segue descrive come Apple utilizza l’apprendimento automatico per dividere le scene in parti naturali da elaborare utilizzando l’imaging computazionale.

«Lo sfondo, il primo piano, gli occhi, le labbra, i capelli, la pelle, i vestiti, il cielo… elaboriamo tutte queste parti in modo indipendente come faresti in camera oscura con molti aggiustamenti locali», afferma McCormack. «Regoliamo tutto: esposizione, contrasto e saturazione, per combinarli insieme… Capiamo come dovrebbe essere il cibo e possiamo ottimizzare il colore e la saturazione di conseguenza per renderlo molto più realistico.

I cieli sono particolarmente difficili da ottenere correttamente e Smart HDR 3 ci consente di isolare il cielo e trattarlo in modo indipendente, quindi rimescolarlo per ricreare in modo più accurato la sensazione che si provava quando lo si vedeva».

McCormack spiega anche le ragioni per cui Apple ha scelto di includere la possibilità di registrare video HDR Dolby Vision nella gamma iPhone 12.

“Apple vuole svelare il complesso settore dell’HDR e il modo per farlo è con ottimi strumenti per la creazione di contenuti. Ciò va dalla produzione di video HDR, che era di nicchia e complicata perché avevo bisogno di telecamere enormi e costose e di una serie di strumenti video che mia figlia quindicenne può ora utilizzare per creare video HDR con Dolby Vision. Presto saranno disponibili molti più contenuti in Dolby Vision. È nell’interesse del settore che ora gli strumenti e la compatibilità aumentino».

I dirigenti parlano anche dei miglioramenti hardware della fotocamera su iPhone 12 e iPhone 12 Pro: «La nuova fotocamera grandangolare e gli algoritmi di fusione delle immagini migliorati portano a una riduzione del rumore e a maggiori dettagli». Anche i progressi specifici della fotocamera iPhone 12 Pro Max meritano una menzione speciale:

«Con Pro Max possiamo andare ancora oltre perché il sensore più grande ci consente di catturare più luce in meno tempo, il che consente un migliore congelamento dei movimenti negli ambienti notturni».

Alla domanda sul motivo per cui Apple ha deciso di aumentare le dimensioni del sensore ora, sull’eniPhone 12 Pro Max, McCormack afferma dal punto di vista di Apple:

«Non è più rilevante per nessuno di noi parlare di una velocità specifica e di un otturatore dell’immagine, o di un sistema fotografico» dice «mentre creiamo il sistema fotografico pensiamo a tutto questo, e pensiamo a tutto ciò che si può fare dal software… puoi optare, ovviamente, per un sensore più grande, che pone problemi di spazio, oppure puoi guardarlo dal punto di vista dell’intero sistema e chiederti se ci sono altri modi per ottenere lo stesso risultato. Quindi definiamo qual è l’obiettivo e si scopre che non è avere un sensore più grande di cui vantarsi. L’obiettivo è come realizzare foto più belle nel maggior numero di situazioni in cui le persone si trovano. Questo è il percorso che ci ha portato alla fusione profonda, alla modalità notturna e all’elaborazione temporale del segnale dell’immagine”.

Molto di più nell’intervista a Sweet e McCormack su PetaPixel.